テンソル分解(英: tensor decomposition)とはテンソルをより階数の少ないテンソル(含む行列やベクトル)の積和で表現する数学的な手法の総称である。行列に対する行列分解のテンソルへの拡張とみなすことができる。

よく用いられるテンソル分解

上述の様にテンソル分解には非常に多彩な自由度が存在するが、主に歴史的な経緯からいくつかのよく用いられる分解が存在する。

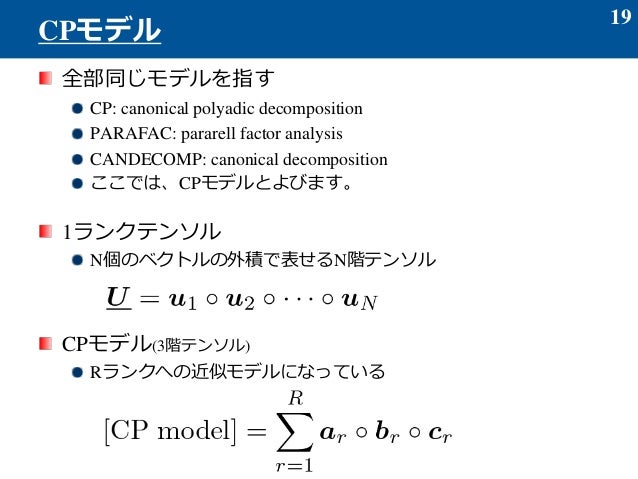

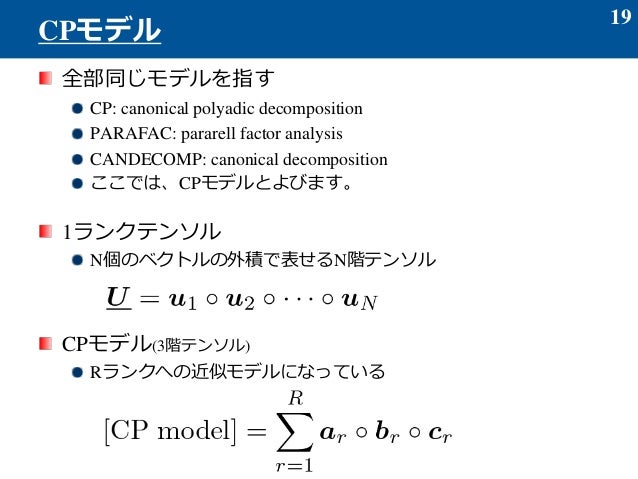

CP分解

CP分解はテンソルをベクトルのクロネッカー積の和で表現する方法である。

ここではm階のテンソル、は次元のベクトルである。は各項の重みを表す係数であり、Rはテンソルのランクと呼ばれる量である。

タッカー分解

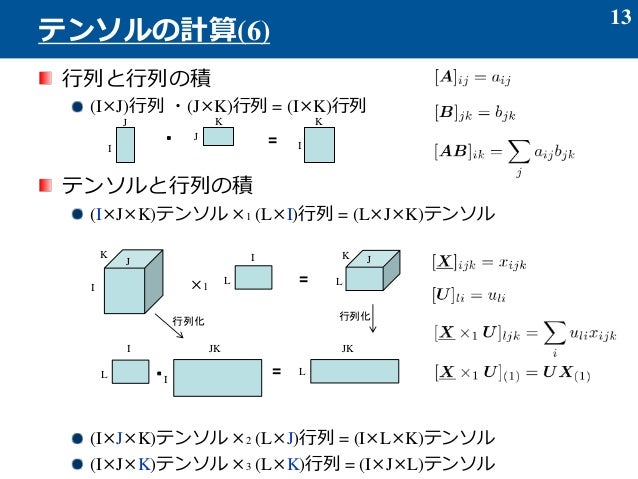

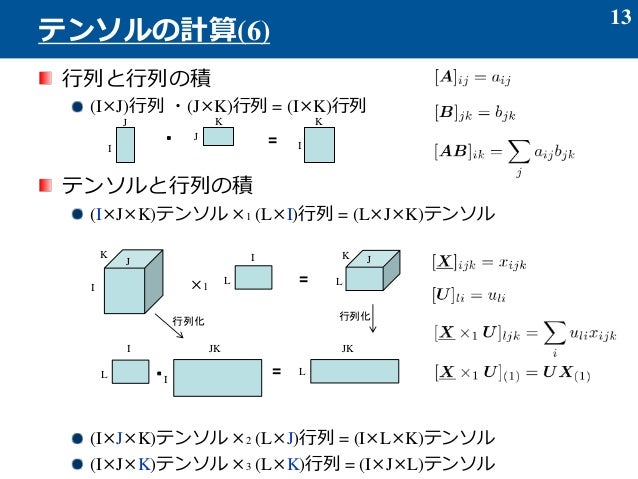

タッカー分解はm階のテンソルをテンソルとベクトルのテンソル積の和で表現する方法である。

但し、は直交行列である。

テンソルトレイン分解

テンソルトレイン分解はテンソルを三階のテンソルのテンソル積の和で表現する方法である。量子力学の分野では、行列積状態(MPS: Matrix Product State)(への分解)とも呼ばれる。

ここでである。

テンソル分解のアルゴリズム

最適化アルゴリズムとしては、CP分解では交互最小二乗法、タッカー分解ではHOSVD(Higher order singular value decomposition)やHOOI(higher order orthogonal iteration)、テンソルトレイン分解ではTT-SVD (Tensor-train singular value decomposition)などが知られている。

脚注

注釈

出典

参考文献

- 石黒, 勝彦; 林, 浩平. 関係データ学習. 講談社. ISBN 978-4-06-152921-2

- Kolda, Tamara; Bader, Brett (2009), “Tensor Decompositions and Applications”, SIAM REVIEW 51 (3): 455-500, doi:10.1137/07070111X

- Andrzej Cichocki; Rafel Zdunek; Anh Huy Phan; Shun-ichi Amari: Nonnegative Matrix and Tensor Factorizations: Applications to Exploratory Multi-way Data Analysis and Blind Source Separation, John Wiley & Sons,ISBN 978-0-470-74666-0 (2009).